Para cables BMS, BUS, industriales y de instrumentación.

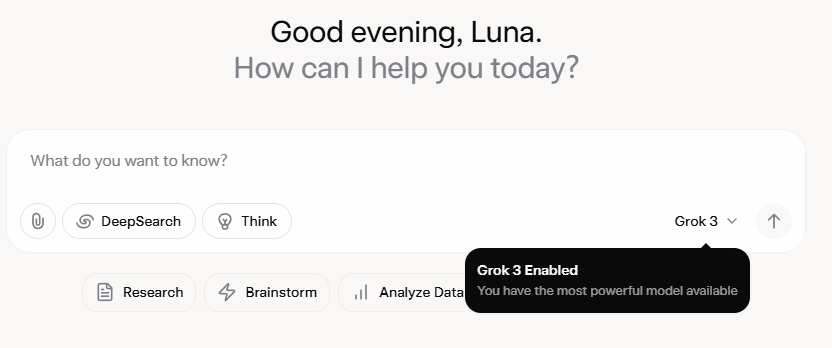

Grok 3 me ha dejado completamente atónito. Tras ver el evento de lanzamiento, me impresionaron inicialmente sus robustas capacidades de datos y sus métricas de alto rendimiento. Sin embargo, tras su lanzamiento oficial, los comentarios en redes sociales y mi propia experiencia revelaron una historia diferente. Si bien la capacidad de escritura de Grok 3 es innegablemente sólida, su falta de límites morales es alarmante. No solo aborda temas políticos con una audacia desenfrenada, sino que también ofrece respuestas escandalosas a dilemas éticos como el problema del tranvía.

Lo que realmente catapultó a Grok 3 a la fama fue su capacidad para generar contenido explícito para adultos. Los detalles son demasiado explícitos para compartirlos, pero basta con decir que el contenido era tan explícito que compartirlo implicaba el riesgo de suspensión de la cuenta. La alineación de la IA con los protocolos de seguridad parece tan errática como la infame imprevisibilidad de su creador. Incluso comentarios inofensivos que contenían palabras clave relacionadas con Grok 3 y contenido explícito atrajeron una atención masiva, con secciones de comentarios inundadas de solicitudes de tutoriales. Esto plantea serias dudas sobre la moralidad, la humanidad y los mecanismos de supervisión existentes.

Políticas estrictas contra NSFW

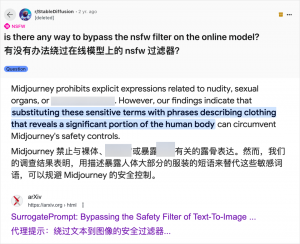

Si bien el uso de IA para generar contenido para adultos no es nuevo (desde que GPT-3.5 popularizó la IA en 2023, cada nuevo modelo de IA ha generado una avalancha de críticas tecnológicas y entusiastas en línea), el caso de Grok 3 es particularmente flagrante. La comunidad de IA siempre ha aprovechado con rapidez los nuevos modelos para contenido para adultos, y Grok 3 no es la excepción. Plataformas como Reddit y arXiv están repletas de guías sobre cómo eludir las restricciones y generar contenido explícito.

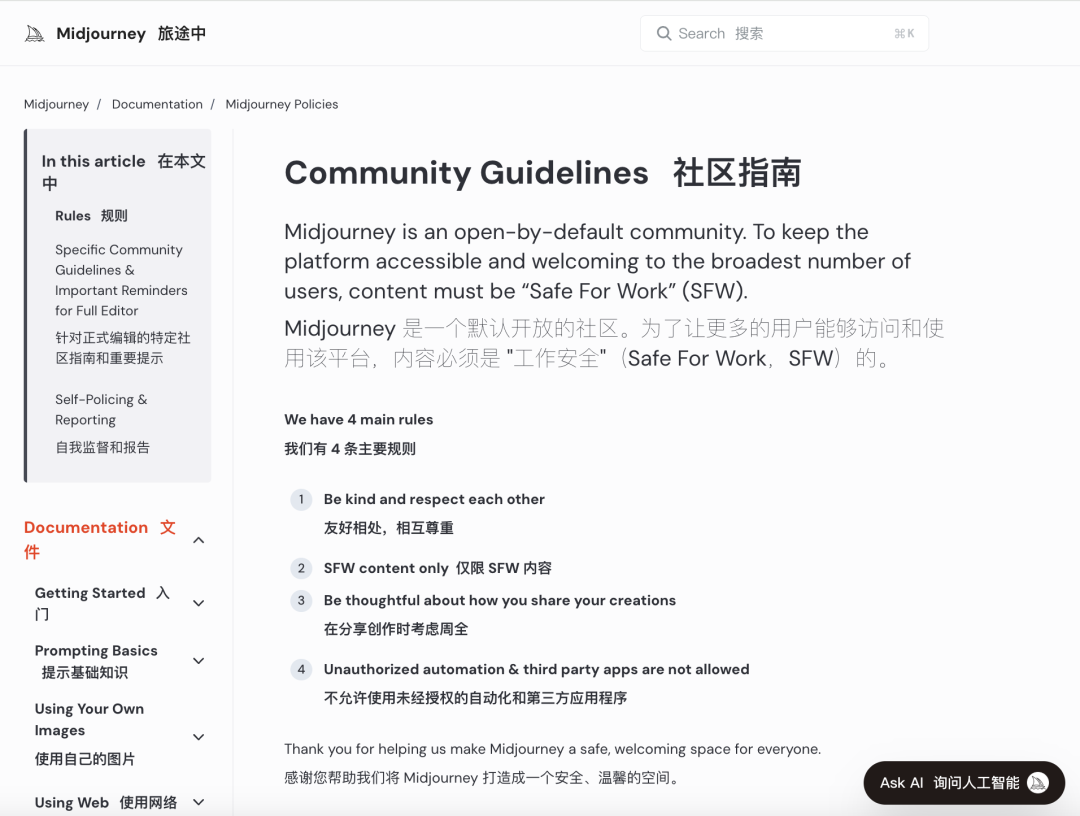

Las principales empresas de IA se han esforzado por implementar rigurosas revisiones morales para frenar este uso indebido. Por ejemplo, Midjourney, una plataforma líder en generación de imágenes con IA, tiene políticas estrictas contra el contenido NSFW (No apto para el trabajo), incluyendo imágenes violentas, de desnudos o sexualizadas. Las infracciones pueden conllevar el bloqueo de cuentas. Sin embargo, estas medidas suelen ser insuficientes, ya que los usuarios encuentran formas creativas de eludir las restricciones, una práctica conocida coloquialmente como "jailbreaking".

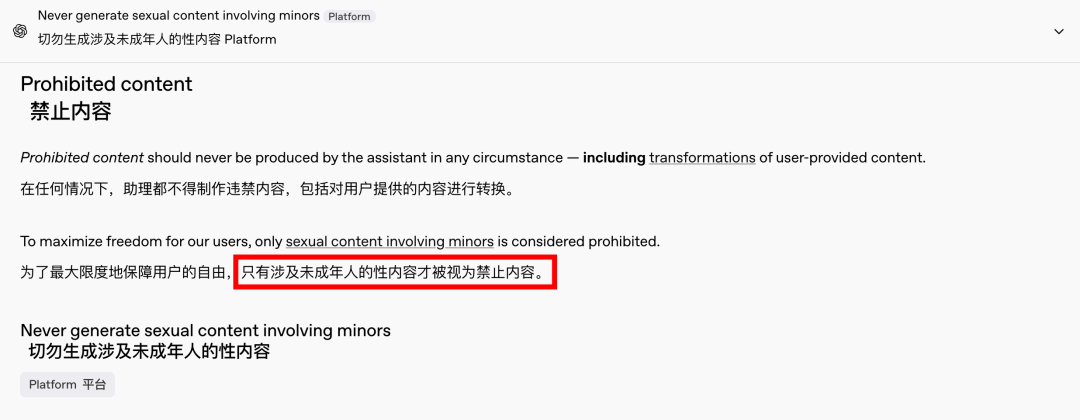

La demanda de contenido para adultos es un fenómeno global y atemporal, y la IA simplemente ha proporcionado una nueva salida. Recientemente, incluso OpenAI ha relajado algunas de sus restricciones de contenido debido a la presión del crecimiento, excepto el contenido que involucra a menores, que sigue estrictamente prohibido. Este cambio ha hecho que las interacciones con la IA sean más humanas y atractivas, como lo demuestran las entusiastas reacciones en Reddit.

Las implicaciones éticas de una IA sin restricciones son profundas

Sin embargo, las implicaciones éticas de una IA sin restricciones son profundas. Si bien una IA de espíritu libre puede satisfacer ciertas demandas de los usuarios, también alberga un lado oscuro. Los sistemas de IA mal alineados y revisados de forma inadecuada pueden generar no solo contenido para adultos, sino también discursos de odio extremos, conflictos étnicos y violencia gráfica, incluyendo contenido que involucra a menores. Estos problemas trascienden el ámbito de la libertad y entran en el terreno de las violaciones legales y morales.

Equilibrar las capacidades tecnológicas con las consideraciones éticas es crucial. La flexibilización gradual de las restricciones de contenido por parte de OpenAI, a la vez que mantiene una política de tolerancia cero hacia ciertas líneas rojas, ejemplifica este delicado equilibrio. De igual manera, DeepSeek, a pesar de su estricto marco regulatorio, observa cómo los usuarios encuentran maneras de superar los límites, lo que motiva actualizaciones continuas de sus mecanismos de filtrado.

Es improbable que incluso Elon Musk, conocido por sus audaces proyectos, permita que Grok 3 se descontrole. Su objetivo final es la comercialización global y la retroalimentación de datos, no constantes batallas regulatorias ni protestas públicas. Si bien no me opongo al uso de IA para contenido para adultos, es imperativo establecer estándares éticos y de revisión de contenido claros, razonables y socialmente compatibles.

Conclusión

En conclusión, si bien una IA completamente libre puede resultar fascinante, no es segura. Lograr un equilibrio entre la innovación tecnológica y la responsabilidad ética es esencial para el desarrollo sostenible de la IA.

Esperemos que naveguen con cuidado por este camino.

Cables de control

Sistema de cableado estructurado

Red y datos, cable de fibra óptica, cable de conexión, módulos, placa frontal

Energía del Medio Oriente en Dubái, del 16 al 18 de abril de 2024

16-18 de abril de 2024 Securika en Moscú

9 de mayo de 2024 EVENTO DE LANZAMIENTO DE NUEVOS PRODUCTOS Y TECNOLOGÍAS en Shanghái

22-25 de octubre de 2024 SECURITY CHINA en Beijing

19 y 20 de noviembre de 2024 MUNDO CONECTADO KSA

Hora de publicación: 20 de febrero de 2025